|

Ярпортал: форум Ярославля  |

Ярпортал в Телеграм Ярпортал в Телеграм  Поиск Поиск  Правила Yarportal.Ru Правила Yarportal.Ru  Политика обработки персональных данных Политика обработки персональных данных

|

| Здравствуйте, Гость ( Вход·Регистрация ) | Сделать Yarportal.Ru стартовой страницей |

|

| Страницы: (6) 1 2 [3] 4 5 ... Последняя » ( Перейти к первому непрочитанному сообщению ) |    |

| GeoHat |

Дата 18.04.2009 - 22:06

|

|

RV870 выйдет в конце июля?

TheJudge / 18.04.2009 20:09 Эта суббота выдалась богатой на предсказания о сроках анонса следующего поколения графических процессоров. Утром мы узнали, что выход GT300 намечен на октябрь этого года, а теперь, с подачи немецкого сайта Heise online сообщаем, что выход первого графического процессора AMD, поддерживающего DirectX 11, состоится в конце июля этого года. Название GPU не сообщается, но большинство источников указывает на кодовое имя RV870. Предполагается, что чип будет выполнен по 40 нанометровому технологическому процессу. Уровень производительности пока остаётся неизвестным. Примечателен тот факт, что обладая более скромными, чем NVIDIA ресурсами, AMD умудряется не только поддерживать темп гонки вооружений, но и опережать конкурента в ряде случаев, к которым может быть, отнесут и выпуск первого GPU с поддержкой DireсtX 11. Также германские журналисты говорят о сроках официального выхода Radeon HD 4770. По их сведениям, это произойдёт в следующий вторник, 28 апреля. |

|

|

|

| GeoHat |

Дата 20.04.2009 - 13:59

|

|

NVIDIA начнёт выпуск 40 нм видеочипов во второй половине этого квартала

Lexagon / 20.04.2009 13:59 На следующей неделе в гонконгские магазины уже могут поступить первые партии видеокарт Radeon HD 4770 на базе первого 40 нм чипа RV740. О планах NVIDIA по переходу на 40 нм технологию известно не так много, что даже создаёт обманчивое впечатление о задержке подобной миграции. Сайт DigiTimes решил напомнить, что NVIDIA готова выпустить 40 нм видеочипы уже в этом квартале. Как сообщает указанный источник со ссылкой на китайское издание Commercial Times, компания NVIDIA определилась с графиком и объёмом заказов, размещаемых в этом квартале на мощностях TSMC и UMC. Прежде всего, будет увеличен объём выпуска чипов GT200b. Этот чип ещё долго будет использоваться для производства флагманских видеокарт NVIDIA, поскольку в качестве предполагаемой даты анонса преемника по имени GT300 называется октябрь или ноябрь. Во второй половине текущего квартала будет освоен выпуск первых 40 нм чипов NVIDIA. Продукты начального уровня будут представлены чипом GT218, к производительному сегменту будет причислен мобильный видеочип GT215, а "средний класс" будут представлять чипы GT214 и GT216. Возможно, к началу сезона "back-to-school" компании NVIDIA удастся существенно обновить ассортимент графических решений.  |

|

|

|

| GeoHat |

Дата 24.04.2009 - 09:31

|

|

Новые подробности о характеристиках GT300

TheJudge / 24.04.2009 05:03 / ссылка на материал / версия для печати Нового графического процессора от NVIDIA рынок уже заждался. Текущий модельный ряд компании состоит из GPU годовалой давности и их аналогов на 55 нанометровом технологическом процессе. Преимущество в производительности флагманского решения над конкурирующим продуктом AMD невелико, а технологическое отставание в поддерживаемой версии DirectX только усугубл@ют положение NVIDIA. Становится понятным, что следующий флагманский чип, известный нам под кодовым именем GT300, должен быть максимально производительным и нести в себе ряд инноваций, чтобы занять доминирующее положение на рынке. Очевидно, NVIDIA приложит для этого все усилия. Тем не менее, о будущем флагмане известно очень немногое. GT300 будет поддерживать DirectX 11, производиться по 40 нанометровому технологическому процессу, а первые решения на его основе поступят в продажу ориентировочно в октябре. Журналисты немецкого сайта Hardware-Infos дополняют портрет нового GPU. По их мнению, чип существенно прибавит в количественных показателях. Число кластеров увеличится с 10 (у GT200) до 16, число блоков выборки текстур при этом пропорционально возрастёт с 80 до 128. Баланс каждого кластера будет смещён в сторону математики с 1:3 до 1:4. Таким образом, в каждом кластере будет 32 потоковых процессора, а общее их число составит 512 штук. Количественными изменениями дело не ограничится. Вычислительные блоки будут поддерживать так называемые MIMD. Не вдаваясь в принципы работы данного функционала, отметим, что это является неким аналогом внеочередного исполнения и Hyper-Threading, и позволит поднять эффективность работы потоковых процессоров на несколько десятков процентов. Кроме того, некоторые источники утверждают, что потоковые процессоры в GT300 будут ещё более независимы и обособлены, чем у первого поколения унифицированной архитектуры, а ожидаемая тактовая частота шейдерного домена составит 2 ГГц. Таким образом, GT300 получится в 2 и более раз сложным и быстрым, чем GT200. На сегодняшний день всё это звучит по меньшей мере крайне оптимистично, ведь первые кристаллы NVIDIA получит только в июне этого года, поэтому не стоит принимать все слухи на веру. Вопросов относительно будущего флагмана осталось немало, в частности, каким образом впишется в архитектуру чипа необходимый по стандартам DirectX 11 тесселятор, а также будут ли переработаны текстурные блоки с целью инклюзивной поддержки возможностей DirectX 10.1. Тем не менее, с учётом известной любви NVIDIA к огромным кристаллам, будущего 40 нанометрового технологического процесса и отсутствию новинок почти год можно предположить, что все силы брошены на GT300 и этот чип будет очень большим и быстрым.  |

|

|

|

| GeoHat |

Дата 27.04.2009 - 14:23

|

|

Первые тесты и изображения Radeon 4770

http://www.3dnews.ru/news/pervii_test_ibes...radeon_hd_4770/ http://www.overclockers.ru/hardnews/32847.shtml |

|

|

|

| GeoHat |

Дата 27.04.2009 - 15:19

|

|

Видеочипы заставят Windows 7 и Apple OS X работать быстрее

Lexagon / 27.04.2009 08:14 Ускорения вычислений силами видеочипов будут поддерживаться как через OpenCL, так и через DirectX. Внедрение первого стандарта позволяет надеяться, что в этой сфере AMD и NVIDIA придут к некоторой общей программной платформе, а владельцы видеокарт на базе чипов их производства смогут на практике почувствовать выгоду от ускорения вычислений силами графических чипов. Представители NVIDIA в интервью сайту CNet сообщили, что технологии ускорения вычислений силами графических чипов будут тесно интегрированы в операционные системы Apple OS X Snow Leopard и Microsoft Windows 7. Если платформа Apple будет опираться на OpenCL, то для Windows 7 соответствующие расширения будут внедрены в DirectX. Видеочипы, например, будут ускорять обработку фотографий или видеороликов - для современных операционных систем потребительского класса это обыденные задачи. Со временем выгоду от внедрения этих расширений на уровне операционных систем почувствует и компания Intel, которая готовится представить в следующем году графические решения семейства Larrabee. Видеочипы станут равноправными участниками повседневной работы, а не узкоспециализированными компонентами.  |

|

|

|

| GeoHat |

Дата 27.04.2009 - 15:20

|

|

Первые 40-нм видеочипы NVIDIA дебютируют в мае-июне

25.04.2009 [15:19], Руслан Цап Согласно информации, озвученной сетевым ресурсом VR-Zone, в мае-июне сего года свет увидят первые GPU от NVIDIA, изготавливаемые по более "тонкому" 40-нм техпроцессу. Как сообщается, дебютантами станут мобильные видеочипы GeForce GT 240M и GeForce G210M, основанные на дизайне GT215 и GT216 соответственно. При этом отмечается, что первый относится к сегменту производительных графических решений и носит условное обозначение N10P-GS, тогда как второй принадлежит к продуктам mainstream-категории и имеет кодовое название N10M-GS. Соответствующие настольные 40-нм изделия, очевидно, будут выпущены позже.  |

|

|

|

| GeoHat |

Дата 4.05.2009 - 14:03

|

|

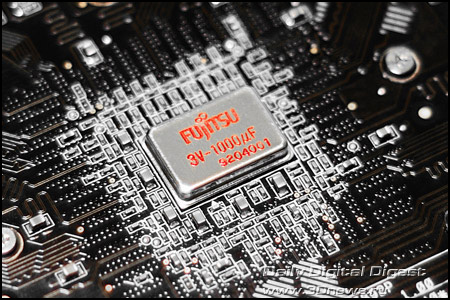

ASUS первой создала видеокарты на конденсаторах Super ML Caps

03.05.2009 [14:37], Руслан Цап Пресс-служба компании ASUSTeK Computer с нескрываемой гордостью объявила о выводе на рынок первых в индустрии настольных дискретных 3D-ускорителей на печатных платах оригинального дизайна, построенных с применением многослойных полимерных конденсаторов Super ML Caps, которые, по заявлениям разработчиков, обеспечивают более стабильное питание, особенно при резком увеличении силы тока в цепи.  Как следует из опубликованного официального сообщения, на суд самых взыскательных геймеров предлагаются четыре "переосмысленные" в плане конструктивного исполнения модели, которыми стали ASUS ENGTX285 TOP/HTDI/1GD3 и ASUS ENGTX285/HTDI/1GD3 на базе NVIDIA GeForce GTX 285, а также ASUS EAH4890 TOP/HTDI/1GD5 и ASUS EAH4890/HTDI/1GD5 на основе ATI Radeon HD 4890. При этом отмечается, что, помимо технологии Super ML Caps, во всех представленных новинках используются более надёжные конденсаторы с твёрдым электролитом, высококачественные залитые дроссели, а также силовые транзисторы с низким сопротивлением канала в открытом состоянии (low RDS(on)). Кроме того, каждое из изделий снабжено электромагнитным экраном (EMI Shield) и отличается завидным разгонным потенциалом, что, несомненно, является выгодными плюсами. Согласно утверждениям производителя, небольшая высота многослойных полимерных конденсаторов Super ML Caps позволяет размещать их ближе к графическому процессору, что делает возможным сокращение длины токоведущих дорожек. В итоге, это привело к уменьшению шума в линиях питания на 15% у видеокарт ASUS ENGTX285 TOP/HTDI/1GD3 / ASUS ENGTX285/HTDI/1GD3 и на 20% у моделей ASUS EAH4890 TOP/HTDI/1GD5 / ASUS EAH4890/HTDI/1GD5.  Примечательно и то, что понижением температуры новых решений на базе ATI Radeon HD 4890 занимается фирменная двухслотовая система активного воздушного охлаждения с крупным радиатором, шестью медными тепловыми трубками и парой вентиляторов, которая способна остудить GPU на 10 градусов по шкале Цельсия ниже, чем референсный кулер. К слову, более подробно о всех конструктивных особенностях данной разработки мы уже рассказывали ранее в нашей новостной ленте. Если же говорить о частотных показателях графического ядра, шейдерных блоков и микросхем памяти GDDR3 объёмом 1 Гб с 512-битным интерфейсом, то они составляют 670/1550/2600 МГц у ASUS ENGTX285 TOP/HTDI/1GD3 и 648/1476/2484 МГц у ASUS ENGTX285/HTDI/1GD3. В свою очередь ASUS EAH4890 TOP/HTDI/1GD5 и ASUS EAH4890/HTDI/1GD5 располагают гигабайтом памяти GDDR5 с 256-битной шиной, а их частотная формула имеет вид 900/4000 МГц и 850/3900 МГц (ядро/память) соответственно. Немаловажно и то, что в версии ASUS EAH4890 TOP/HTDI/1GD5 успешно реализована фирменная технология Voltage Tweak Technology, которая позволяет посредством программной утилиты SmartDoctor увеличивать напряжение питания GPU c 1,3 В до 1,4 В, чего вполне достаточно для возможности дальнейшего повышения рабочих частот с 900/4000 МГц вплоть до отметок 1000/4800 МГц.  |

|

|

|

| GeoHat |

Дата 4.05.2009 - 14:49

|

|

|

| phantomm |

Дата 4.05.2009 - 16:00

|

|

Может не новость уже, но мне показалось интересным, и про f@h не забыли упомянуть

PhysX, теперь от NVIDIA – чего ждать от старой новой технологии? Много воды утекло с тех пор, как компания Ageia, основанная в 2002 году в Санта-Кларе, впервые заговорила о важности интеграции физических вычислений в игровые приложения. По мнению Ageia, это позволило бы добиться на порядок более реалистичного и качественного игрового процесса. Первоначальная концепция компании предполагала наличие специальной платы PPU (Physics Processing Unit, Модуль Обработки Физики) для аппаратного ускорения физики, однако со временем от этой задумки не осталось и следа ввиду ее неэффективности и экономической нецелесообразности. Но вопреки неудаче с аппаратным PPU, сама идея ускорения физики была подхвачена индустрией и сегодня получила серьезное развитие. Мы попробуем разобраться, что же дает игровая физика, как ее можно использовать, и стоит ли вообще игра свеч. Легко представить ситуацию масштабного взрыва в игре. К сожалению, в большинстве случаев визуализация такого, казалось бы, естественного и часто используемого эффекта оставляет желать лучшего – вместо сотен частиц, недавно бывших частью целостного объекта, мы наблюдаем какую-нибудь текстуру не самого высокого разрешения, достаточно посредственно имитирующую происходящее. Можно привести и куда более миролюбивые примеры – игры с действительно правдоподобной, а не просто красивой водой можно пересчитать по пальцам. Как было бы здорово понаблюдать за водопадом, подчиняющимся законам Ньютона, а не желаниям разработчиков! Или же посмотреть на развевающуюся подвижную одежду на персонажах вместо статичной, как будто прилипшей к моделям... Все это, по задумке Ageia, и должно было стать сегодняшней реальностью. Однако из-за того, что задумка была действительно нова и не слишком отработана, технология не пошла в массы. Платы для ускорения физических эффектов были слишком дороги, соответственно приобретались единицами, разработчики же прекрасно понимая это не стали поддерживать инициативу, прибегая к традиционным приемам в игрострое. Действительно очевидно, что нет никакого смысла внедрять в игру поддержку каких-либо неочевидных технологий, в нашем случае PhysX, если большинство геймеров просто не смогут воспользоваться заявленными преимуществами. Это занимает время, которое могло быть потрачено на более важные аспекты игры, ресурсы компании и т.д. Серьезно рисковать в игровой индустрии никто не любит. В конце концов, Ageia осознала, что затея близка к провалу, конкуренты вроде Havok, не требующие отдельного оборудования, наступают и сначала свернула производство плат PhysX, а затем и сконцентрировалась на PhysX API, как чисто программном физическом движке для обычных центральных процессоров. Хотелось бы на этом месте написать стандартную для сказок хэппи-энд концовку в стиле «… и стало у Ageia с тех пор все замечательно, и индустриальным стандартом был признан PhysX API», но не тут-то было. Идеей ускорения физики достаточно давно интересовалась NVIDIA, а в свете продвижения своей вычислительной платформы CUDA, у «зеленой» корпорации появился отличный повод вместо начала разработки своей технологии «с нуля» с потрохами купить компанию, а API портировать на CUDA для использования своими видеокартами. В конце прошлого года так и произошло – за 30 миллионов долларов Ageia была перекуплена калифорнийскими соседями и перестала существовать как отдельная организация, а основной штат занялся переносом API на видеокарты NVIDIA. С этого момента для нас и начинается самое интересное. Ведь несмотря на то, что фактически затея самой Ageia не удалась, получаемые результаты в тех немногочисленных играх, где была реализована поддержка технологии, были впечатляющими. И теперь, с релизом последней на данный момент версии драйверов ForceWare за номером 177.83 от 12 августа, любой пользователь видеокарт GeForce с поддержкой CUDA (т.е. восьмой серии и выше) может воспользоваться преимуществами ускорения физики PhysX без установки отдельной платы, как это было ранее. По статистике NVIDIA, технологией PhysX смогут воспользоваться более 70 миллионов обладателей GeForce по всему миру. Именно этой реинкарнации PhysX и посвящена сегодняшняя статья. Кстати, данные о статистике приведены неспроста. Помните, в начале статьи мы говорили о том, что любая технология, пусть даже самая совершенная и отработанная, может получить распространение только при реально большом количестве возможных пользователей. Именно с этим Ageia просчиталась, продавая задорого свои карты PhysX – они оказались просто никому не нужны. Теперь же NVIDIA делает ставку на более чем 70 миллионов GPU, которые потенциально могут стать заодно и ускорителями физики (а надеяться на это действительно стоит, F@h для GeForce прекрасно себя оправдывает, побивая все рекорды производительности). Для того, чтобы продемонстрировать на что способна новая технология, NVIDIA вместе с новыми драйверами представила набор PhysX Pack, в который входят несколько технических демонстраций, патчи для существующих полноценных игр и даже отдельные мини-игры. Сегодня мы рассмотрим реализацию PhysX от NVIDIA, расскажем, как задействовать новые возможности графических ускорителей. Заранее скажем, что полный спектр возможностей доступен только при наличии нескольких GPU семейства GeForce в системе, однако и для одиночных карт припасено немало интересного. Приступим же! Согласно словарному определению, физика – наука, изучающая материю, энергию, движение и силы. Русский язык не передает этой тонкости, однако, название технологии PhysX было выбрано неспроста – торговая марка созвучна с английским словом physics, как раз и обозначающим науку, столь нелюбимую многими в детстве. Возникает логичный вопрос – а как же все это связано с реальными играми? Игровая физика – все то, как двигаются и взаимодействуют объекты. В привычном понимании вещей всю работу по просчету этих взаимодействий выполняет центральный процессор (у которого вполне себе ограниченная производительность, которой должно хватить на огромное количество ежесекундных расчетов кроме игровой физики). Несмотря на то, что в подходе NVIDIA эта обязанность переложена на графический процессор, не следует думать, что GeForce PhysX рендерит графику. Пусть отныне и задействован GPU, используется он именно в расчетах, а графика остается графикой. То есть, как и ранее, PhysX отвечает за сложные движения объектов, элементарных частиц, флюидов и т.д. с поправкой на реалистичную гравитацию, ветер, густоту среды, плотность веществ и так далее, а уже после этих расчетов происходит обычный графический рендеринг. Из-за того, что ранее физику приходилось рассчитывать средствами CPU, уже и так серьезно загруженного работой (один только искусственный интеллект в современных играх чего стоит), приходилось упрощать сложные расчеты, прибегать к округлениям и условностям, вследствие чего падала реалистичность. Более того, не существовало стандартного унифицированного подхода к созданию игровой физики – Ageia конечно продвигала свой PhysX API, да и Havok различных версий использовался во многих играх, но в любом проекте происходили доработки «под себя». Конечно, это высвобождает процессорные ресурсы и одновременно еще сильнее нагружает графическую систему, однако раз NVIDIA считает возможным сохранить баланс между расчетами физики и графики силами графических плат, значит, для этого действительно есть основания. Теперь, благодаря наличию унифицированной аппаратной базы огромной мощности (вспомните математические возможности GT200) и единому средству разработки от NVIDIA, у разработчиков появилась возможность не задумываться о выборе физического движка и моделировать физику более качественно. Вот некоторые из заявленных возможностей GeForce PhysX: * Реалистичные взрывы, поднимающие клубы пыли, и сопутствующие разрушения с обломками и осколками * Моделирование персонажей с куда более сложной, нежели существующая сейчас, анимацией и более «живым» поведением * Возможность создания впечатляющих видов оружия с невероятными эффектами * Реалистичное моделирование ткани, собирающейся в складки или рвущейся «по-настоящему» * Плотный дым и туман, обволакивающий движущиеся объекты Все это теперь может быть рассчитано на видеокартах, причем по заявлениям NVIDIA намного быстрее, чем на CPU (а верить этим заявлениям стоит, вспомните производительность видеоконвертеров, оптимизированных для унифицированной шейдерный архитектуры GeForce). В качестве примера, где кое-что из заявленного уже сейчас реально работает, можно привести Tom Clancy’s Ghost Recon Advanced Warfighter 2. В игре упор сделан на реализм, разработчики сознательно уделили огромное внимание проработке физики, так как без этого GRAW 2 потерял бы существенную долю своей привлекательности. Например, хорошо видно, как на скриншоте при взрыве граната разрывает ящик на частицы, которые бы не были отрисованы и просчитаны без PhysX, причем даже производительности современного двухядерного CPU было бы недостаточно. BFG Ageia PhysX accelerator card Многие некомпетентные источники в Сети размещают обзоры NVIDIA PhysX, в которых говорят, что ускорение физики улучшит фреймрейт и плавность игры. К сожалению, авторы таких заявлений неправы – PhysX никогда не был предназначен для того, что бы заставить игры «бегать» быстрее. Конечно, при некоторых исключениях такая возможность присутствует, однако в нормальной ситуации использование продвинутой физики от бывшей Ageia наоборот приводит к падению производительности. Это вполне логично, неважно, о чем мы говорим – об отдельной плате, или же об ускорении физики силами GPU – физический движок рассчитывает лишь взаимодействие объектов, а сами объекты, коих при взрыве может стать в сотни раз больше, должны быть отрисованы видеокартой. Иными словами, получается две ситуации: * Если вычисления PhysX производятся с помощью GPU в сильно процессорозависимой игре, и это разгружает процессор, то FPS может вырасти (вопрос только в том, что такие игры можно пересчитать по пальцам одной руки, а с учетом того, что обычно в паре с мощной видеокартой в системе установлен далеко не бюджетный процессор...); * Если же игра более требовательна к графической подсистеме, получается, что и без того ограниченные ресурсы GPU расходуются на физические расчеты, а потом видеокарте приходится рисовать еще и более сложные кадры – налицо все условия для падения количества FPS. Еще раз повторимся – работа, которую проделывает ускоритель физики, ускоряет именно физику. Если выстрелить во взрывоопасную бочку, PhysX рассчитает только поведение частиц, а вот видеокарте придется рендерить фрейм со всеми этими частицами с увеличившимся количеством текстур, шейдеров и повысившимися требованиями к скорости заполнения сцены. Это самая весомая причина, по которой предложенное NVIDIA решение не очень рационально. Да, использование PhysX серьезно улучшает реалистичность картинки, однако это может приводить к значительным провалам производительности, так что стоит всякий раз подумать, стоит ли жертвовать FPS во имя физики. Однако, как мы уже говорили в начале статьи, NVIDIA позаботилась о балансе и предложила отличное решение этой непростой проблемы. Пожалуй, стоит поблагодарить программистов бывшей Ageia и NVIDIA за проделанную работу. Благодаря их усилиям у пользователей теперь есть несколько возможностей задействовать ускорение физики на видеокартах: * Стандартный вариант, использование одного GPU для одновременной обработки и графики, и физики (как нам уже ясно – далеко не оптимальный вариант, необходим слишком мощный GPU); * Режим SLI – на установленные в SLI видеокарты подается распределенная нагрузка из рендеринга и задач PhysX; * Режим Multi-GPU – также требует пары видеокарт в системе, однако четко разделяет обязанности так, что одна карта занимается только графикой, а вторая – только физикой. GeForce PhysX На наш взгляд наиболее интересным выглядит несимметричный во всех отношениях третий вариант. Еще давным-давно схожий режим первой обещала ATI для своих Crossfire связок, однако, на данный момент он все еще не реализован. Согласитесь, отличным способом задействовать старый видеоадаптер может стать его превращение в аналог PhysX карты, при этом графическая производительность основной видеокарты не пострадает (имеется в виду от расчета физики). Вполне реальна ситуация, когда пользователь меняет какой-нибудь GeForce 8600 GTS или 9600 GT на новенький GTX 260. В таком случае старую карту можно не продавать за бесценок, а разумно использовать – PhysX не требует сверхпроизводительных карт вроде GTX 280, хотя и их использовать, конечно, можно. Кстати, еще одним примечательным моментом данного режима является отсутствие привязки к nForce платформе. Если для организации SLI необходим чипсет семейства nForce, установленный на материнской плате, то для установки PhysX-видеокарты в дополнение к основной требуется лишь второй слот PCI-Express Graphics, а сейчас большинство современных плат обладают парой таких слотов. Не стоит забывать и о том, что если вы выберете путь добавления дополнительных графических карт для активации Multi-GPU, или даже SLI конфигурации, естественным следствием помимо положительных эффектов для физики или графики станет и рост энергопотребления системы. Использование пары мощных видеокарт даже в режиме покоя может поднять требования системы до 200 Вт, чего уж говорить о работе под 100%-нагрузкой. Так что, если вы не уверены в мощности своего блока питания, стоит в первую очередь озаботиться этой проблемой, чтобы вместо прелестей PhysX не получить нестабильную систему. В наших тестах мы использовали материнскую плату на базе nForce 680i, процессор Core 2 Duo, работающий на частоте 3 ГГц и пару видеокарт – мощную GeForce GTX 280 для графики и 9600 GT для физики. Наши замеры показали, что в пике нагрузке при использовании таких комплектующих потребление системного блока может составить внушительные 432 Вт. Ясно, что если использовать более производительную, чем 9600 GT, карту, потребление только лишь увеличится. Сегодня 9600 GT в тестовой системе была представлена пассивно-охлаждаемой версией от Sparkle, и, как уже отмечалось ранее, карта использовалась исключительно для PhysX. Дабы не ограничивать по возможности результаты тестирования, в качестве видеокарты была выбрана гордость NVIDIA – GeForce GTX 280. Отдельной проблемой Multi-GPU, которая на данный момент не решена, является необходимость подключения монитора (или ТВ, любого схожего устройства) к дополнительной видеокарте, занимающейся обработкой PhysX. Согласно данным NVIDIA, это недостаток Windows Vista, возможно в скором времени последует исправление этой ошибки, и можно будет ограничиться подключением основного монитора к видеокарте. При ускорении PhysX средствами одиночной видеокарты, или пары GPU в SLI режиме, схожих проблем нет. После сборки системы мы загрузили операционную систему, установили последние драйверы ForceWare 177.83, а затем софт PhysX версии 8.07.18, после чего компьютер был перезагружен. На наш взгляд было бы логичным размещение настроек PhysX в общей ForceWare Control Panel, однако соответствующий значок появляется в обычной Панели Управления Windows. Затем следует настроить параметры работы монитора, подключенного ко второй графической плате, например, расширив рабочий стол на него (убедитесь, что основной в системе является мощная графическая карта и главный монитор подключен именно к ней). После этих действий кликнув дважды на значок GeForce PhysX можно получить доступ к необходимым нам опциям. GeForce PhysX Device Selection Настроек немного, следует лишь выбрать GPU, который будет заниматься ускорением физики. На одной из вкладок содержатся схематичные демонстрации тех эффектов, о которых мы говорили ранее. А теперь давайте рассмотрим, что приготовила нам NVIDIA в составе PhysX Software Pack, приуроченного к релизу драйверов, поддерживающих PhysX на GPU. К сожалению, времени на тестирование было немного, но пропустить эту игры было бы просто преступлением. В Software Pack входит кумулятивный патч для игры до версии 1.5, который привносит поддержку GeForce PhysX в GRAW2. Побочным, особо приятным эффектом является удаление всех сохраненных игр. Красота, как говорится, требует жертв, так что пришлось проходить Ghost Recon с самого начала до уровней, на которых мы обычно проводим тесты. Правда, позитивный момент оказался в том, что представилась возможность посмотреть на игру под новым углом и проверить все заявления NVIDIA о возможностях PhysX на деле. В настройках игры после установки драйверов и описанной выше процедуры настройки появился пункт PhysX Quality Settings, мы установили его значение на Extreme для того чтобы посмотреть все, на что способен PhysX в GRAW2. GRAW2 advanced settings Первое, что бросилось в глаза – намного более подвижные от ветра деревья и огромное количество присутствующих на картах частиц, движущихся также с учетом направления ветра. Присутствуют и обещанные реалистичные облака пыли, возможно, даже смоделированные на основе мягких частиц. Создаваемая игрой атмосфера стала заметно глубже, несмотря даже на то, что количество FPS немного упало, относительно игры без PhysX. Благодаря дополнительным деталям погружение в игровой процесс действительно впечатляет, наголову превосходя GRAW2 с обычной физикой. GRAW2 По результатам тестов очевидно, что, как мы и предполагали, лучшим выбором стала связка GeForce GTX 280 для графики и выделенная 9600 GT для физики. С другой стороны, по современным меркам Ghost Recon 2 не очень требовательная игра, и в нашем случае даже в разрешении 2560 x 1600 одиночная GTX 280 отлично справлялось и с расчетами физики, и с рендерингом, держа планку FPS на высоком уровне. Конечно, с более GPU-зависимыми играми так поиграть уже не получится, но полученные данные только еще раз подчеркивают математическую мощь GT200. В свой PhysX Pack NVIDIA также включила полную версию специально разработанной для демонстрации физики игры Warmonger. Warmonger Демонстрация вышла очень убедительная. Уже с первых минут обучения игра показывает все, на что способен PhysX – везде тучи мелких частиц, реалистично двигающаяся ткань, постоянно меняющая свое положение от внешних воздействий. Конечно, на полноценную игру Warmonger не тянет, так как был создан специально по заказу NVIDIA и является фактически расширенным техно-демо, однако реализация физики находится на первоклассном уровне. К сожалению, скриншоты не могут передать реальной анимации и в статике не выглядят впечатляюще, однако поверьте на слово, если у вас нет возможности посмотреть PhysX в действии самим – в динамике ощущения потрясающи. В Warmonger можно также оставить включенными эффекты физики отключив GeForce PhysX, однако это значит переложить аппаратное ускорение с плеч GPU на CPU, что даст в итоге абсолютно удручающую картину производительности. Только посмотрите на графики! Они красноречиво доказывают превосходство GPU над CPU в физических расчетах. Графические платы в действительности намного более эффективно справляются с поставленной задачей. Warmonger бенчмарк Как и все входящие в PhysX Pack составляющие игра бесплатна, и если у вас есть GPU с поддержкой CUDA, а это вся восьмая серия GeForce и выше, попробовать Warmonger можно совершенно даром. Warmonger Video Options Общие слова, сказанные о Warmonger, действительны и в отношении Metal Knight Zero. Игра входит в состав PhysX Software Pack, является бесплатной, и, хотя NVIDIA и присваивает MKZ статус полноценной игры, она таковой не является. Это еще одна техническая демонстрация, только акцент здесь скорее сделан уже на взрывах. Они проработаны действительно потрясающе – газовые баллоны взрываются феерично, оставляя за собой сотни частиц и огромные клубы дума. От одного такого взрыва могут остаться более 2000 микрочастиц. Очень впечатляет. В игре встроен бенчмарк, запустив его, мы получили такие результаты: MKZ бенчмарк Опять же игра предлагает отказаться от ускорения физики средствами GPU. Отставание CPU в таком случае от графических карт еще сильнее бросается в глаза, чем в Warmonger. Жаль, что нет возможности отключить PhysX вообще, для того чтобы получить результаты с учетом разгруженности и CPU и GPU от сложных физических расчетов. Metal Knight Zero Многие, посмотрев на скриншоты, предположат, что Nurien – еще один способ увидеть красиво нарисованных девушек. Конечно же, девелоперы это отрицают. Разработчики обещают, что техно-демо выльется в глобальную социальную игру вроде Second Life, где особое внимание будет уделено одежде персонажей (ну и, конечно же, тому, как все это отлично обрабатывается PhysX’ом). Уже сейчас визуальная составляющая выглядит отлично, можно также создавать свой образ. Игра основана на движке Unreal Engine 3, что объясняет простую адаптацию к PhysX (UE3 изначально поддерживал данную технологию). Выглядит демонстрация отменно, видно, что Ньютоновская физика здесь везде, от развевающихся волос до складок платьев и клубов цветного дыма на заднем плане. Nurien Nurien Кстати об UE3. В пак PhysX будут также входить три специальные карты и патч для оптимизации UT3 под физику от NVIDIA. Это совершенно отдельная история, выходящая за рамки статьи, однако если у вас есть Unreal Tournament третьей редакции, посмотреть обязательно стоит. Ну, в этот раз хотя бы слово Demo вынесли прямо в название очередной программы из вышедшего набора NVIDIA. Движок здесь – все тот же UE3, Demo является совместной разработкой программистов NVIDIA и Ageia. Сам Kulu – некое большое слизистое существо инопланетной внешности. Сначала существо обездвижено и находится в защитном поле. Своими действиями мы это поле отключаем, и существо начинает охоту за игроком. Конец демонстрации особо примечателен, но описывать мы его не будем, чтобы не испортить, например, аппетит, читающим статью. Как и полагается, PhysX везде и повсюду, в очередной раз NVIDIA доказывает, что раньше наша игровая жизнь без этой технологии была никчемна. В целом The Great Kulu просто демонстрирует, каких возможностей визуализации физических эффектов можно ожидать от грядущих игр. The Great Kulu Demo А вот последняя демонстрация, проходящая по нашему сегодняшнему списку, пожалуй, является самой впечатляющей. Фактически, ничего сложного демо не показывает – всего лишь то, как вода попадает из точки А в точку Б. Однако то, как это продемонстрировано, просто завораживает. Смоделированы, похоже, все известные законы физики, и учтены все важные параметры веществ. В демонстрации показана небольшая база с массивной трубой, находящейся на крыше одного из зданий. Именно из этой трубы и льется жидкость, характеристики которой задаются пользователем, от консистенции до цвета. Внизу располагается бассейн, в который можно набросать твердые ящики и посмотреть, как реалистично они будут взаимодействовать. Fluids Tech Demo Несмотря на то, что Fluids выполнена не в виде игры, именно тут у NVIDIA получилось лучше всего показать возможности PhysX. Обязательно посмотрите демонстрацию, если не на настоящей карте, то хотя бы на YouTube. Если говорить кратко, сегодняшнее тестирование нас впечатлило. Благодаря стараниям NVIDIA доступно несколько вариантов аппаратной реализации PhysX , в частности подробно рассмотренный нами режим Multi-GPU. Если ваша графическая карта не в состоянии справляться с одновременной обработкой и графики, и физики, достаточно просто добавить дешевую карту вроде 8600 GT, чтобы устранить досадное недоразумение. Если же вы обладатель мощной платы последнего поколения, вроде GTX 280, достаточно будет возможностей и одного этого GPU, чтобы без проблем играть со включенным PhysX. Протестированный сегодня вариант комбинации GeForce GTX 280 и дополнительной 9600 GT показал себя с лучшей стороны. Ни в одном приложении карты не разочаровали, причем производительность такой пары была бескомпромиссна во всех режимах. Эти карты могут стать прекрасным выбором для построения high-end системы с ориентацией на PhysX с нуля. На самом деле горизонты возможностей раздвинуть можно еще шире. Например, уже сейчас в продаже доступны материнские платы на базе GeForce 8200 с графическим ядром, также поддерживающим обработку PhysX. Достаточно добавить внешнюю видеокарту и подключить встроенную графику для обработки PhysX, чтобы из бюджетного ПК сделать мощную игровую машину. Как мы уже отмечали, крайне положительным моментом в новой реализации PhysX является уже существующая огромная база карт, поддерживающих CUDA, и, соответственно PhysX. Причем самое интересное в том, что буквально на днях появились новости об энтузиастах, портировавших драйверы NVIDIA PhysX на видеокарты ATI! Более того, сделано это было не без поддержки программистов NVIDIA, которые, очевидно, заинтересованы в максимально широком распространении технологии. В любом случае, даже если такие эксперименты останутся просто не очень удачными попытками, ничто не мешает объединить в одной системе видеокарту Radeon для рендеринга графика и GeForce – для физики. AMD пока не поддерживает никаких обособленных технологий, делая ставку на DirectX 11, Intel же уже давно купила Havok, так что в скором времени, похоже, нас ждет противостояние не только концепций рендеринга графики, но и обработки физики. К сожалению, несмотря на законченность представленного NVIDIA решения, корпорации все равно необходимо заручаться поддержкой производителей, организовывая что-то вроде физического аналога программы The Way It’s Meant To Be Played. Основной недостаток, приведший AGEIA к неудаче – слабая поддержка со стороны игростроителей – все так же не устранен. Игр с поддержкой PhysX, пусть и в удачном исполнении на GeForce, просто мало. Упомянутый DX11, который, между прочим, выходит уже через 18 месяцев, будет поддерживать новый тип микропрограмм, Compute Shaders, и очевидно, что универсальный API будет предпочтительнее для разработчиков. При этом, в общем и целом развитие физического ускорения уже дошло до такого уровня, что игнорировать это девелоперам нельзя, и, очевидно, что в новых играх на физику будет обращаться особое внимание. А что же с процессорными расчетами? Похоже, что физика, ускоряемая CPU, доживает последние дни. Есть задачи, решаемые на классической архитектуре x86 быстрее, другие же эффективнее работают на унифицированных шейдерных архитектурах, вроде Graphics Tesla от NVIDIA. Ускорение физики явно относится ко второй группе, что однозначно показало сегодняшнее тестирование. Даже не очень быстрая по современным меркам 9600 GT в состоянии обеспечить необходимую производительность для расчетов PhysX любой сложности. В это же время Core 2 Duo не справляется, опуская планку FPS ниже допустимого уровня. NVIDIA старается донести PhysX как можно большему числу пользователей, анонсируя различные бесплатные игры и демонстрации, вроде рассмотренных нами сегодня. По заявлениям компании, это только первая волна, следует ожидать и PhysX Software Pack 2, и т.д. В заключении хочется еще раз поблагодарить NVIDIA за проделанную работу. Ведь мало того, что PhysX позволяет добиться действительно качественного моделирования физики, корпорация открывает доступ к новому поколению физических эффектов еще и бесплатно! Раньше карта PhysX продавалась за 249 долларов, а сейчас достаточно иметь многофункциональный GPU с поддержкой CUDA и установленные драйверы, чтобы получить схожие результаты. PhysX – действительно интересная технология, превосходно реализованная. Попробовав единожды поиграть с PhysX, хочется видеть эффекты такого же высокого уровня и в остальных играх. Пожалуй, наиболее ожидаемые игры с реализацией физики от NVIDIA – Empire: Total War и Mirror's Edge. А сейчас действительно стоит посмотреть технологию в действии, например, в GRAW2 с установленном патчем версии 1.5. Или же в Unreal Tournament 3 с PhysX модом. Если вы обладаете видеокартой с поддержкой CUDA, т.е. GeForce 8 и выше, просто скачайте пак, предлагаемый NVIDIA, и вы не останетесь разочарованы. оригинал статьи здесь: http://www.nix.ru/computer_hardware_news/h....html?id=152145 |

|

|

|

| GeoHat |

Дата 13.05.2009 - 12:01

|

|

NVIDIA GT300: мощнее и позже, чем ожидалось

08.05.2009 [13:00], Геннадий Пашкевич Около двух недель назад близкие к производству источники сообщили, что графический процессор нового поколения RV870, обещающий принести видеокартам AMD поддержку DirectX 11, будет представлен этим летом. Оптимистически настроенные информаторы не только назвали конкретную дату анонса - 7 августа, но и поделились сведениями об ожидаемом быстродействии будущего решения и уровне превосходства над нынешним флагманом компании AMD, ускорителем Radeon HD 4890 на ядре RV790. А что известно о графическом чипе NVIDIA GT300? Когда конкурирующий лагерь выпустит свой первый DX11-совместимый продукт? В поисках ответов на эти вопросы обратимся к свежим слухам, распространённым в сети Интернет. По сообщению британского ресурса The Inquirer, компания NVIDIA выйдет на рынок с графическим процессором GT300 не раньше первого квартала будущего года. Поначалу некоторые источники считали, что калифорнийцы представят DX11-совместимую архитектуру в начале текущего года. Чуть позже заговорили о переносе сроков на четвёртый квартал, точнее, на октябрь. Теперь же утверждается об очередной отсрочке на несколько месяцев. Британский источник не уточняет, что именно заставило компанию NVIDIA перенести анонс флагманского чипа на следующий год. Причины можно искать как в лабораториях разработчиков, так и в отделе маркетинга. Кроме того, свои коррективы могли внести проблемы с новым 40-нм техпроцессом компании TSMC. В последнее время в прессе периодически появляются слухи о невысоком уровне выхода годной продукции, изготовленной по новейшим технологическим нормам. При производстве больших и сложных чипов данная проблема становится особенно актуальной. Что касается остальных запланированных на текущий год 40-нм решений, все они должны выйти в соответствии с прежним графиком. Первыми продуктами NVIDIA, выпущенными по более "тонкому" техпроцессу, станут мобильные графические чипы из семейства GT21x. Вернёмся к будущему флагману NVIDIA, кодовое имя которого созвучно с названием модели популярной автомагнитолы производства Sony и спортивной версии автомобиля Toyota Corolla, представленной в начале этого года на автосалоне в Токио. Графический чип GT300 обещает быть довольно производительным решением. По данным немецкого сайта Hardware-Infos, инженеры NVIDIA планируют оснастить новинку 512 потоковыми процессорами. Это значительно больше, чем было озвучено в самых ранних прогнозах. К тому же, унифицированные конвейеры перейдут от модели вычислений SIMD (один поток команд, множество потоков данных) к MIMD (множество потоков команд, множество потоков данных). Новое графическое ядро будет состоять из 16 процессорных кластеров. В каждом из них должно разместиться по 32 потоковых конвейера. Если каждому шейдерному кластеру будут по-прежнему соответствовать 8 текстурных блоков (TMU), как в GT200, то их общее количество вырастет до 128 штук. Видеобуфер объёмом 1024 или 2048 Мб будет соединён с графическим ядром посредством 512-бит шины. Применение высокоскоростных микросхем GDDR5 позволит добиться впечатляющей пропускной способности памяти. Заметим также, что наиболее вероятным рыночным названием будущей флагманской видеокарты на чипе GT300 считается GeForce GTX 380.  |

|

|

|

| GeoHat |

Дата 20.05.2009 - 11:08

|

|

Информация о частотах первых образцов GT300

Lexagon / 19.05.2009 09:50 / ссылка на материал / версия для печати Интернет-ресурсы Bright Side Of News и Hardware-Infos в рамках очередной совместной новости сообщили, на каких частотах работают первые образцы видеокарт на базе чипа GT300 производства NVIDIA. Как известно, этот видеочип получит 512 потоковых процессоров и 512-битную шину памяти. Частоты имеющихся образцов видеокарт на базе чипа GT300/G300 равны 700/1600/4400 МГц для ядра, шейдерного домена и памяти соответственно. Первые образцы видеокарт оснащаются 1 Гб памяти типа GDDR-5, в перспективе возможен выход версии с 2 Гб памяти этого типа. Конечно, это лишь предварительные данные о частотах видеокарт на базе GT300/G300, к моменту анонса многое может измениться.  |

|

|

|

| GeoHat |

Дата 20.05.2009 - 13:30

|

|

nVidia CUDA: тесты приложений на GPU для массового рынка

Это сообщение отредактировал GeoHat - 20.05.2009 - 13:31 |

|

|

|

| GeoHat |

Дата 24.06.2009 - 15:07

|

|

Раскрываем спецификации ATI Radeon HD 4790

14.06.2009 [09:43], Руслан Цап Благодаря стараниям одного из участников форума VR-Zone стала доступна пока ещё официально не подтверждённая информация о некоторых технических характеристиках грядущего графического адаптера ATI Radeon HD 4790 компании Advanced Micro Devices (AMD). Как сообщается, решение построено на базе изготавливаемого по 55-нм технологии чипа RV790 с 800 потоковыми процессорами. При этом новинка укомплектована памятью GDDR5 объёмом 512 Мб с 256-битным интерфейсом, которая функционирует на частоте 3200 МГц, тогда как рабочая частота видеоядра равна 600 МГц. Предположительно, производительность Radeon HD 4790 может находиться между ATI Radeon HD 4870 и ATI Radeon HD 4850. О вероятных сроках официального анонса продукта пока ничего не известно.  |

|

|

|

| GeoHat |

Дата 25.06.2009 - 10:56

|

|

NVIDIA официально выпускает 40 нм GPU

TheJudge / 16.06.2009 16:48 / ссылка на материал / версия для печати Рынок и рядовые пользователи уже заждались новых GPU от NVIDIA. Тоски ожидания не смог сгладить ни переведённый на 55 нм технологический процесс GT200, ни переименованный в четвёртый раз G92. NVIDIA понять тоже можно. Выпускать линейку новых GPU на старом технологическом процессе большого смысла нет, да и текущие представители успешно удерживают целевые рыночные ниши. Доступность 40 нм техпроцесса у TSMC дала, наконец, необходимый стимул NVIDIA для выпуска долгожданного обновления GPU среднего ценового диапазона, пока, к сожалению, только для ноутбуков. Дискретные видеокарты на основе новых GPU будут представлены только в июле и августе. Такая необычная для анонсов NVIDIA политика обусловлена небольшими объёмами производства с использованием новых технологических норм, которые не позволят удовлетворить массовый спрос, но вполне справятся с потребностями рынка ноутбуков. Желающие могут ознакомиться с новой линейкой на официальной странице, а мы пока рассмотрим эту самую линейку и её возможности. Стоит отметить тот факт, что необычность анонса заключается ещё и в завуалированности подаваемой информации. В частности NVIDIA не сообщает открытым текстом ни кодовые названия новых GPU, ни полного перечня их характеристик, возможностей и даже архитектурных изменений. К счастью, по косвенным признакам можно сделать ряд нужных выводов. Итак, всего было представлено пять решений, которые обновят практически всю линейку, за исключением старших моделей на базе G92:  Обновление прошло в ключе “до +100% производительности и до -50% энергопотребления старых решений в данном сегменте”. Неплохо. Но не будем заострять внимание на позиционировании, уподобл@ясь красноглазому небритому человеку на слайде, и перейдём к рассмотрению характеристик новых чипов:  Судя по всему, линейку представляют три GPU. Известны и их кодовые имена – GT215, GT216 и GT218. Младший, который положен в основу GeForce G 210M, является, скорее всего, очередной версией G98. Он оснащается 64-битной шиной памяти, 16 потоковыми процессорами и внушительными тактовыми частотами. Второй GPU дал жизнь двум решениям - GeForce GT 230M и GeForce GT 240M. Они имеют 48 потоковых процессоров (2 кластера) и ограничиваются поддержкой GDDR-3. Замыкают линейку GeForce GTS 250M и GeForce GTS 260M, основанные на “старшем” чипе. Возможности этих чипов несколько шире - 96 потоковых процессоров (4 кластера) и поддержка GDDR-5. Очевидно, что два последних чипа вобрали в себя лучшие стороны архитектуры GT200 – наличие 24 потоковых процессоров в кластере, вместо 16, а также удвоенный регистровый файл. О поддержке вещественных вычислении с двойной точностью (FP64) ничего не сообщается. Изюминкой новых чипов стало не только использование 40 нм техпроцесса, но и наличие поддержки DirectX 10.1. Это потребовало хоть небольшой, но доработки блоков растеризации, что должно благоприятным образом сказаться на их производительности. Тем не менее, пока множество вопросов остаётся открытыми. Это и соответствие кодовых имён новых GPU решениям на их основе, подробности об изменениях в архитектуре и блоках растеризации, полный спектр возможностей и предельные тактовые частоты. Остаётся надеяться, что ответы на эти вопросы мы получим в ближайшее время.  |

|

|

|

| bankuss |

Дата 30.07.2009 - 10:57

|

|

23 ватта это уже хорошо. вот такую я бы купил

|

|

« | Компьютеры и мобильные телефоны | »

Страницы:

(6) 1 2 [3] 4 5 ... Последняя »

Страницы:

(6) 1 2 [3] 4 5 ... Последняя » |

|

[ Время генерации скрипта: 0.0117 ] [ Использовано запросов: 15 ] [ GZIP включён ]

Используя Yarportal.Ru, вы соглашаетесь с Правилами Yarportal.Ru и Политикой обработки персональных данных.

Powered by Invision Power Board(U) v1.3 Final © 2003 IPS, Inc.